INTELLIGENZA ARTIFICIALE: TUTELA DEI DATI ED INNOVAZIONE RESPONSABILE NEI RAPPORTI DI LAVORO

Il Consiglio dei ministri n. 78 del 23 aprile 2025 ha approvato il disegno di legge sull’Intelligenza artificiale (il “DDL AI”) che integra a livello nazionale la disciplina dettata dal Regolamento (UE) 2024/1689 (cd. AI ACT).

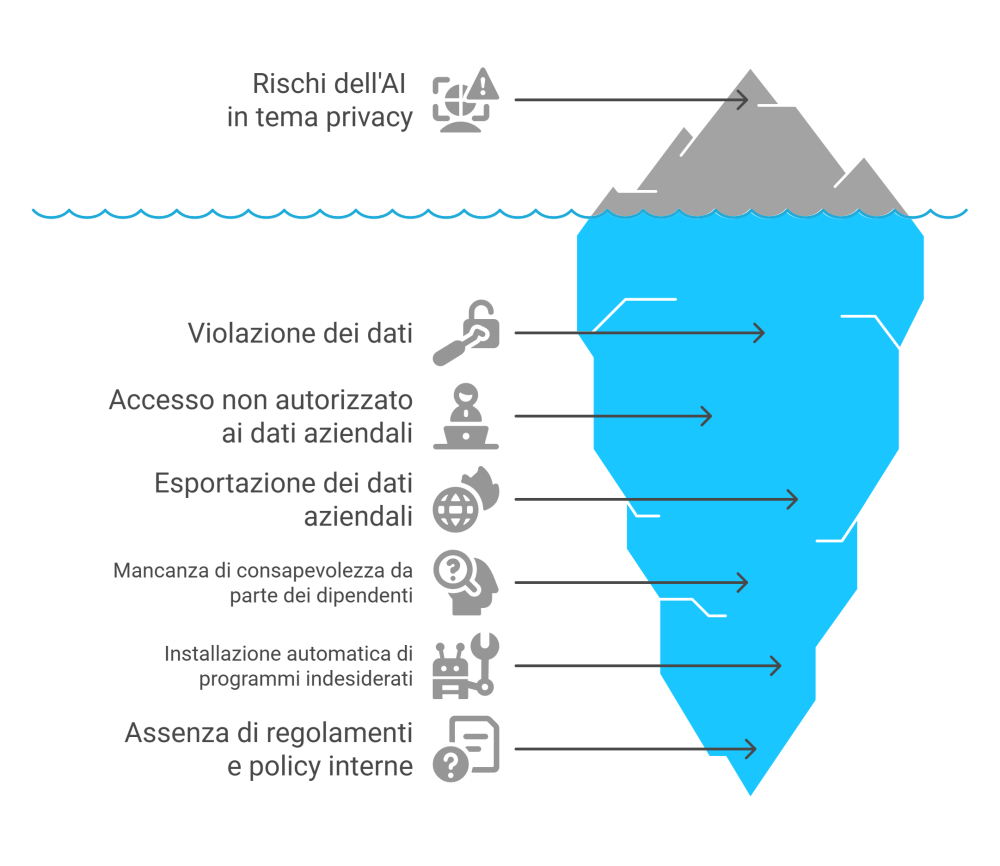

Negli ultimi anni, l’Intelligenza Artificiale (AI) sta modificando radicalmente i modelli operativi delle aziende, introducendo, da un lato vantaggi in termini di produttività ed automazione, ma d’altra parte amplificando i rischi sul piano della tutela dei dati personali e della sicurezza aziendale.

Nel contesto della normativa europea, dapprima mediante il Regolamento europeo GDPR e la Direttiva NIS 2 e successivamente con il Regolamento (UE) 2024/1689 sull’Intelligenza Artificiale (AI ACT), ha iniziato a trovare regolamentazione il quadro normativo volto ad apprestare a favore del prestatore di lavoro una rete di tutele specifiche rispetto ai rischi derivanti dall’impatto dell’Intelligenza Artificiale, nel mondo del lavoro.

In particolare, l’AI ACT inquadrando i sistemi di AI che incidono sui diritti dei lavoratori come sistemi ad alto rischio, ha introdotto una serie di tutele crescenti.

Ad oggi, la normativa nazionale ed in particolare il DDL AI ha chiarito i contesti di utilizzo dei sistemi AI in ambito lavorativo ed, in particolare, condizionandone l’utilizzo al miglioramento delle condizioni di lavoro, alla tutela dell’integrità psico-fisica dei lavoratori ed al miglioramento delle qualità delle prestazioni lavorative e la produttività delle persone, in conformità al diritto dell’Unione europea.

L’Autorità ha più volte sottolineato che l’impiego non controllato di sistemi generativi può comportare violazioni della disciplina in materia di protezione dei dati, specie se utilizzati senza policy chiare e con l’inserimento inconsapevole di dati personali o aziendali sensibili.

Il Garante per la protezione dei dati personali ha recentemente evidenziato l’importanza dell’uso consapevole degli strumenti di intelligenza artificiale (IA) da parte dei dipendenti. In particolare, in un’audizione del 7 maggio 2024, il Presidente del Garante, Prof. Pasquale Stanzione, ha sottolineato che: “l’adozione di sistemi decisionali o di monitoraggio automatizzati nel contesto lavorativo deve essere accompagnata da adeguate garanzie per i lavoratori. Queste includono l’obbligo per i datori di lavoro di fornire informazioni trasparenti sull’uso di tali sistemi e di effettuare valutazioni d’impatto sulla protezione dei dati personali, come previsto dal Regolamento (UE) 2016/679 (GDPR)[1] .”

Inoltre, il Garante ha ribadito che l’utilizzo di strumenti di IA non deve compromettere la libertà e la dignità dei lavoratori, evitando forme di controllo eccessivamente invasive o discriminatorie. È essenziale che le aziende adottino politiche interne chiare ed introducano una formazione adeguata al personale sull’uso responsabile dell’AI, al fine di garantire la conformità alle normative sulla protezione dei dati personali e di tutelare i diritti dei dipendenti.

Sempre più spesso l’intelligenza artificiale viene integrata nei flussi di lavoro: generazione di contenuti, supporto alle attività amministrative, rassegne stampa, gestione dei social media, ricerca documentale, assistenza personalizzata. Esistono oggi strumenti AI generativi in grado di coprire ogni fase del lavoro: dal brainstorming iniziale alla redazione di testi, fino alla sintesi e revisione dei documenti.

In questo scenario, non è l’uso in sé degli strumenti AI a rappresentare il rischio principale, ma il loro uso inconsapevole e non regolamentato. È frequente l’installazione di estensioni o plugin su browser e dispositivi aziendali, anche in modo automatico, senza che vi sia consapevolezza delle implicazioni in termini di trattamento e localizzazione dei dati.

Secondo il Rapporto annuale del Garante Privacy 2023, una quota crescente di violazioni segnalate riguarda proprio la gestione non corretta dei dati da parte dei dipendenti o l’utilizzo improprio di strumenti digitali aziendali[2]. In questo contesto, la cultura della protezione dei dati deve diventare parte integrante della strategia aziendale, specie laddove l’automazione diventa un fattore competitivo.

Il rischio riguarda non solo i dati dei dipendenti, ma anche quelli di clienti, utenti e partner. Alcuni strumenti AI, soprattutto quelli che operano in cloud pubblico, trasferiscono dati a server situati fuori dallo Spazio Economico Europeo, con possibili violazioni dei principi di liceità, limitazione della finalità, minimizzazione, accountability.

La capacità predittiva dei sistemi di AI – di profilare abitudini, preferenze, comportamenti – solleva preoccupazioni crescenti in relazione alla libertà di autodeterminazione e alla concreta possibilità di prevenire effetti discriminatori o automatismi decisionali non trasparenti. La privacy emerge come presidio contro il rischio di determinismo algoritmico, che può limitare la libertà individuale basandosi su pattern passati o modelli di gruppo.

La protezione dei dati personali, come ha più volte ribadito il Garante, non è un ostacolo all’innovazione, ma un prerequisito della fiducia. In particolare, la privacy non è solo un diritto strumentale, ma si configura sempre più come elemento essenziale della dignità umana nell’era digitale. Preservare spazi di riservatezza significa tutelare la possibilità di sviluppare liberamente la propria personalità, mantenere relazioni autentiche, e sperimentare idee non convenzionali al riparo da un monitoraggio pervasivo.

Le imprese, i DPO e i professionisti sono chiamati a:

- adottare policy aziendali vincolanti sull’uso degli strumenti AI;

- redigere informative specifiche nei casi in cui i dati personali siano trattati da strumenti automatizzati;

- implementare misure tecniche e organizzative adeguate (art. 32 GDPR);

- effettuare valutazioni d’impatto (DPIA) nei casi in cui vi sia un rischio elevato per i diritti e le libertà degli interessati;

- prevedere formazione continua, pratica e multidisciplinare, che includa simulazioni, test e scenari di rischio realistici.

Per questi motivi, l’istruzione del personale sull’uso responsabile dell’AI non è più un’opzione: è un obbligo di governance che necessita di strategie adeguate e di costante aggiornamento.

In definitiva, l’equilibrio tra innovazione tecnologica e rispetto della normativa privacy non è solo un obbligo giuridico, ma una scelta strategica di sostenibilità, su cui si misura l’affidabilità e la reputazione di ogni organizzazione nell’economia digitale.

[1]https://www.garanteprivacy.it/home/docweb/-/docweb-display/docweb/10011530?utm_source=chatgpt.com

[2]https://www.garanteprivacy.it/home/docweb/-/docweb-display/docweb/10032023

Avv. Elisabetta Ricchiuti

Counsel | MFLaw Milano

Condividi